¿Los coches autónomos deben decidir por las personas ante imprevistos?

Como entusiasta de la tecnología, me resulta especialmente interesante explorar las implicaciones éticas y los dilemas morales que surgen al programar coches autónomos para tomar determinadas decisiones en situaciones de riesgo.

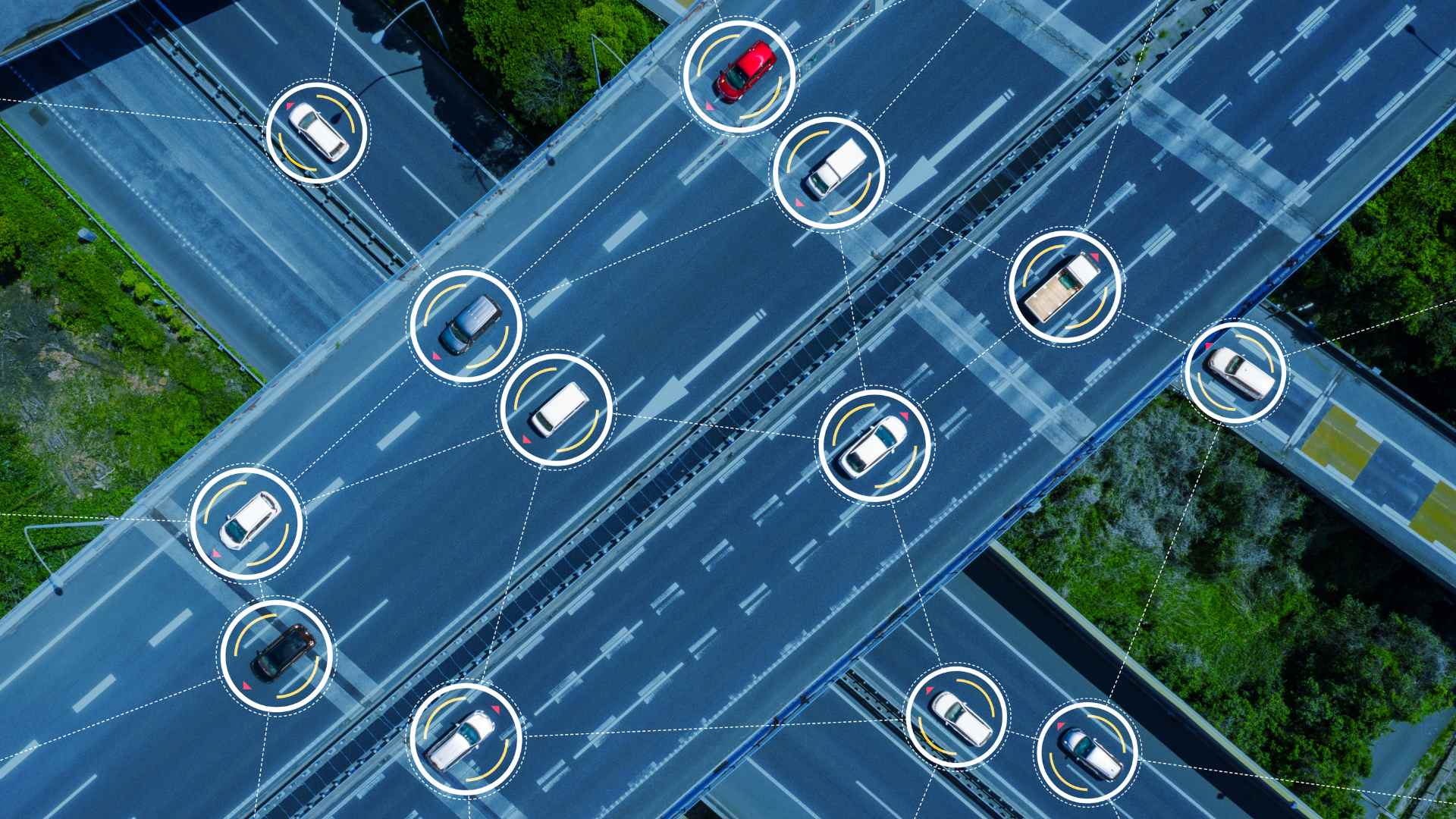

El avance tecnológico en la industria automotriz ha llevado a la creación de vehículos capaces de tomar decisiones por nosotros en tiempo real. Estos automóviles, equipados con sensores y algoritmos sofisticados, tienen el potencial de reducir los accidentes de tráfico y salvar vidas. Sin embargo, al otorgarles la capacidad de decidir por sí mismos en situaciones de riesgo sustituyendo casi al completo a las personas como primera opción, nos encontramos ante una pregunta crucial: ¿cómo deben programarse estos vehículos para que puedan tomar la mejor decisión ante un dilema moral sin la intervención humana?

Imaginemos una situación en la que un automóvil autónomo se encuentra en una encrucijada. De repente, un peatón aparece en la vía, mientras que otro vehículo se aproxima a alta velocidad. El coche tiene que tomar una decisión instantánea: ¿debe priorizar la seguridad del pasajero y evitar el accidente, o debe proteger al peatón arriesgando la vida del pasajero?

Aquí es donde emerge de manera prominente el quid de la cuestión. ¿Qué valor debemos otorgar a la vida humana; ¿debemos priorizar la vida del conductor o la de los peatones?; ¿existe alguna diferencia si los peatones son jóvenes o ancianos? ¿Sería capaz algún día un coche autónomo de diferenciar las características de los viandantes como la edad o la altura para actuar ante una situación de riesgo?

Así pues, la programación de los coches autónomos plantea una serie de implicaciones éticas y morales. Los desarrolladores deben tomar decisiones cruciales sobre cómo se deben comportar estos vehículos en situaciones límite. Se han propuesto, pues, diferentes enfoques, como la priorización de la vida humana en general o la protección del mayor número de vidas posible. Sin embargo, ninguna solución es perfecta y todas conllevan consecuencias éticas.

Por otro lado, también debemos considerar cómo las preferencias culturales y sociales influyen en la programación de estos coches. Lo que se considera éticamente correcto en una cultura puede diferir en otra. Por lo tanto, es necesario establecer estándares éticos y legales universales para garantizar la coherencia y la equidad cuando se fabriquen este tipo de vehículos.

Seguro que recordaréis el impactante video en el que un Tesla pierde el control con el conductor dentro del vehículo y arroya, a más de 200 km/h, a varios viandantes matándolos en el acto. La culpa fue del conductor. La culpa la tuvo el propio vehículo. Existen versiones contradictorias. Aún así y si realmente fue el conductor del Model Y quien pisó el acelerador, ¿no debería haber frenado igualmente el Tesla si estaba circulando en una carretera no apropiada para alcanzar tal velocidad? ¿Dónde queda el equilibrio entre seguridad, automatización y criterio personal?

A medida que avancemos en esta era de coches autónomos, debemos fomentar un diálogo abierto y continuo sobre la ética de la conducción. Solo a través de una colaboración integral entre expertos en ética y tecnología podremos establecer estándares éticos que reflejen nuestros valores y prioridades como sociedad.

Nos obstante, como individuos, también debemos asumir nuestra responsabilidad si acompasamos esta tecnología, además de considerar los aspectos éticos que correspondan. Al hacerlo, estaremos contribuyendo a una sociedad más ética y consciente en la era de los automóviles autónomos, pero todavía queda mucho camino por recorrer.

¿Crees que un coche debería tener criterio proprio? Y si es así, ¿debería primar la acción humana o la tecnología? ¡Cuéntame tu opinión en los comentarios!